Googleがマルチサーチを発表。その背景とは

Googleは、2022年4月7日、同社ブログにおいてオンラインショッピングをより快適にするための検索体験である”multisearch”(マルチサーチ)を新たに発表しました。

※参考リンク:

Googleでは膨大な検索データから、例えばどういったアパレル商品が人気があるかなど、トレンドは把握しているものの、商品を購入する際に人々がどのようにインスピレーションを得ているのかを理解するために、アパレル、ビューティ、ホームインテリアの商品を購入する米国人2,000人を対象に調査を行い、Inspired Shopping Reportを発表しました。そこからわかったことの概要は以下の通りです(詳しい調査結果の数字などはブログ原文を参照ください):

- アパレル、ビューティ、ホームインテリア関連の商品を購入する人の多くは、購入する前に2週間ほどかけて商品をリサーチしている。

- 特に何かを探しているわけでもないのに、しばしば、あるいはときどきネットショッピングやブラウジングをする。

- 積極的に買い物をしていないときでも、しばしば、あるいはときどき、何かを買いたくなるようなインスピレーションを受ける。

- 誰かが着ているのを見て、オンラインで特定の服を探すことがよくある、またはときどきある。

- 気に入った洋服、アクセサリー、インテリアのスクリーンショットを撮ったり、その後に検索したり購入したことがある。

- 特定の衣類や家具をオンラインで探す際に、言葉だけで説明しようとして失敗したことがよくある、またはときどきある。

- 別の色やプリントの商品を見つけたいと考えている。

より統合的な検索結果の表示

まず一つ目の取り組みとして、オンラインショッピングをより簡単に、より楽しくするために、ファッションやアパレルに関するショッピングのクエリに対して、より統合的な検索結果が出るようになりました。Googleでファッションやアパレル関連のキーワードで検索すると、さまざまな色やスタイルのビジュアルフィードが、地元のショップ、スタイルガイド、ビデオなどの役立つ情報とともに表示されます。

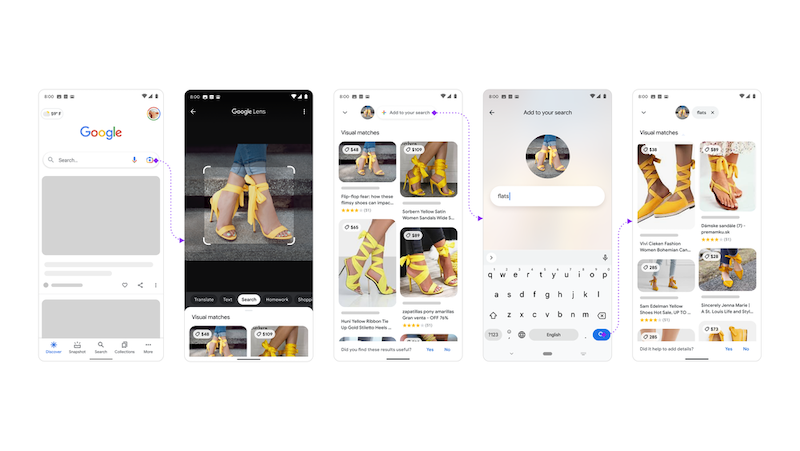

マルチサーチ

2つ目はマルチサーチ機能の追加です。Google Lensは、AndroidまたはiOS端末上で動くアプリで、写真やスクリーンショットを撮るだけで、まったく同じ、または似たような結果が見つかり、そこから買い物をすることができるものですが、Lensのマルチサーチ機能を使えば、テキストと画像を同時に使って検索することができます。

- たとえば、手持ちのバッグと同じ柄のスカーフを探している場合、Lensでその柄のハンドバッグの写真を撮って、出てきた検索結果に対して、”+ Add to your search”(追加でサーチ)ボタンを押して、「スカーフ」というクエリを追加すれば、あなたのルックは完成です。

- お気に入りのヒールの写真を撮って、「フラットシューズ」というクエリを追加すれば、より快適な類似商品を見つけることができます。

- スタイリッシュなオレンジのドレスをスクリーンショットし、「グリーン」というクエリを追加して他の色のドレスを探すことができます。

- ダイニングセットの写真を撮って、「コーヒーテーブル」というクエリを追加して、お揃いのテーブルを探せます。

- ローズマリーの写真を撮って、「お手入れ方法」のクエリを追加することもできます。

これらはすべて、最新の人工知能の進歩によって可能になったもので、今後はMUM(検索における最新のAIモデル)によって強化していくことを検討しているとしています。この機能は、本日付けで米国で英語版のベータ版として提供されています。

今回の発表についてのコメント

今回の発表についてのコメントは以下の通りです。

- ここ最近続いている、大手プラットフォームによるショッピング体験機能の向上の一環。Googleは総合的な情報力を出してきた印象です。検索結果がいろんなフォーマットの情報で埋め尽くされることに関してのユーザーの反応はどうなのだろうと思う部分はありますが、このようにベータとして世に出す以前に、相当ユーザーテストを繰り返し、レベニューニュートラル(機能追加変更による売上がプラマイゼロ以上)は維持しているはずなので、自信はあるのかと思います。

- 世の中でここまでモバイル端末が一般に普及し、その中でもカメラは多くの人が使う機能になったこともあり、Lensの可能性は感じてました。また、膨大な写真を商品とマッチングさせる高度な技術、そもそもの商品情報を広範囲(世界中のあらゆる商品の膨大なDB)に持ち合わせることができるのは、やはり大手グローバルプラットフォームになりますので、本腰を入れてきたLensの活用がどこまでユーザーに普及するか、注目したいと思います。